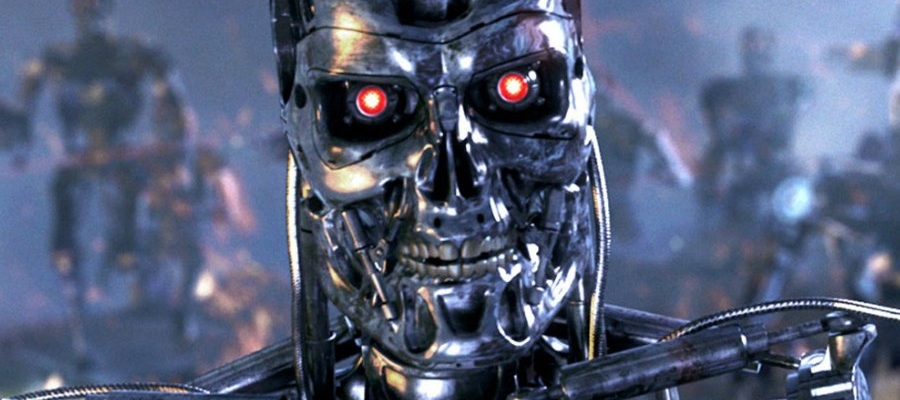

Stephen Hawking, Elon Musk, Noam Chomsky ja tuhanded teised kutsuvad valitsusi üles keelustama tehisintellektiga varustatud tapjaroboteid

- Varia

- 12.08.2015, 14:44

Kirja väitel on täiesti autonoomsete tapjamasinate loomine võimalik “juba aastate, mitte aastakümnete pärast”

Enam kui tuhat eksperti robootika ja tehisintellekti alal – teiste seas ka füüsik Stephen Hawking, tehnoloog Elon Musk ning filosoof Noam Chomsky – on allkirjastanud avatud kirja, milles kutsutakse valitsusi üles keelustama “autonoomseid ründerelvi” või nagu neid paremini tuntakse – “tapjaroboteid”.

Teiste allakirjutanute hulka kuuluvad Apple’i suurfirma kaasasutaja Steve Wozniak ning sajad tehisintellekti ja robootika alal tegutsevad teadlased parimatest ülikoolidest ning laboritest üle kogu maailma.

Kõnealune kiri, mille koostas “inimkonna püsimajäämist ähvardavate ohtude” ennetamise nimel tegutsev Future of Life instituut, hoiatab “sõjalise tehisintellekti võidurelvastumisega” kaasneva ohu eest.

Selliste robotrelvade hulka võivad kuuluda ka relvastatud droonid, mis suudavad oma programmi alusel otsida ja tappa kindlaid inimesi; see on järgmine samm edasi praegustest droonidest, mida juhivad inimesed, kes on sageli sõjategevusest tuhandeid kilomeetreid eemal.

Kirjas seisab nõnda: “Tehisintellekti tehnoloogia on jõudnud punkti, kus selliste süsteemide kasutuselevõtt on praktiliselt, kui mitte seaduslikult, teostatav juba aastate, mitte aastakümnete pärast.”

Kiri lisab veel, et autonoomseid relvi “võib kirjeldada kui sõjategevuse kolmandat suurt pööret püssirohu ja tuumarelvade leiutamise järel”.

Kirja sõnul näeb instituut “tehisintellektis suurt potentsiaali inimkonnale mitmel moel kasu toomiseks,” aga usub samas, et robotrelvade arendamine seda ei tee; selliseid relvi võivad kasutada terroristid, julmad diktaatorid ja inimesed, kes soovivad läbi viia etnilist puhastust.

Selliseid relvi pole küll veel päriselt olemas, aga kaugel pole tehnoloogia, mis võimaldaks neid praktikas kasutada. Sarnaselt kirjale allakirjutanutele usuvad selle tehnoloogia vastased, et inimsõdurite surma ohu kõrvaldamisega vähendaksid robotrelvad (mille loomiseks vajalik tehnoloogia muutub lähimate aastate jooksul üha odavamaks ja kättesaadavamaks) vastumeelsust sõja alustamiseks, mis võib tulevikus sõjad sagedasemaks muuta.

Möödunud aastal avaldas Lõuna-Korea sarnaste relvade kasutuselevõtu. Relvastatud valverobotid on praegu paigaldatud Lõuna- ja Põhja-Korea piirile. Nende robotite kaamerad ning soojustundlikud sensorid võimaldavad neil inimesi automaatselt sihtida, aga masinad nõuavad tulistamiseks siiski inimese käsku.

Kiri hoiatab ka võimaliku mõju eest avalikule arvamusele tehisintellekti rahumeelsete kasutusvõimaluste kohta, millest võiks inimkonnale kõvasti kasu tõusta. Robotrelvade ehitamine võib aga kasvatada avalikkuse pahameelt ja seeläbi piirata tehisintellekti tõelisi eeliseid.

Kogu see jutt kõlab küll väga futuristlikult, aga see tehnoloogiavaldkond areneb hoogsalt ning samuti kasvab tehisintellekti vägivaldse kasutamise vastaste hulk.

Nende hulka kuulub ka tapjarobotite peatamise kampaania ÜRO-ga seotud grupi eesmärk on keelustada teatud tavarelvade kasutamine, teiste seas ka maamiinid ja laserrelvad, mis keelustati ennatlikult 1995. aastal ning millele lisanduvad kampaania lootusel ka autonoomsed relvad.

Kampaania püüab lasta konventsioonil kokku kutsuda valitsusekspertide rühma, mis arutleks seda küsimust eesmärgiga sarnased relvad keelustada.

Käesoleva aasta algul oli Suurbritannia ÜRO konverentsil vastu tapjarobotite kasutamise keelule. Välisministeeriumi ametnik ütles ajalehele The Guardian, et Suurbritannia “ei näinud mingit vajadust keelustamaks” autonoomseid relvi, lisades sealjuures, et Suurbritannia parajasti selliste relvade arendamisega ei tegele.

Allikas: www.independent.co.uk

Tõlkis: Joonas Orav

Uuri lisaks:

- Future of Life Instute’i kodulehelt futureoflife.org tehisintellekti ja robootika ekspertide avalikku kirja autonoomsete relvade ohust inimkonnale ja vaata, kes on sellele alla kirjutanud

- Organisatsiooni Human Right Watch hoiatuskirja sellest, kuidas tapjarovotid tuleks keelata enne kui on liiga hilja

- Vaata kampaania lehelt stopkillerrobots.org kuidas ise kaasa lüüa kui see teema on sulle südamelähedane